Введение

В этот раз я хочу рассказать вам об одной из самых важных вех в развитии как нейрофизиологии, так и непосредственно кибернетики. Сейчас я говорю с одной стороны про формулировку первого работающего правила обучения искусственных нейронных сетей, а с другой стороны про попытку приблизиться к тайнам обучения живых существ.

Сегодня мы пройдем путь от изначального вида постулата Хебба к его непосредственному применению, а также попробуем обсудить возможность его применения для моделирования обучения в системах искусственного интеллекта.

К написанию данной статьи меня побудили комментарии к моим предыдущим топикам, в которых мне было необходимо выражать свое отношение к обучению за счет изменения силы синаптической связи. Поэтому я решил один раз разобрать все подробно, в том числе для самого себя.

История и изначальная формулировка

Канадский нейропсихолог Дональд Хебб шел к окончательной формулировке своего «нейрофизиологического постулата» достаточно долго, публикуя различные его версии в ранних статьях. Однако, окончательный вид он приобрел в 1949 в самом значимом труде Хебба – «The Organization of Behavior: A NEUROPSYCHOLOGICAL THEORY» [1].

В данной книге постулат Хебба звучит следующим образом: «When an axon of cell A is near enough to excite a cell B and repeatedly or persistently takes part in firing it, some growth process or metabolic change takes place in one or both cells such that A's efficiency, as one of the cells firing B, is increased». (стр. 62 в издании 2002 года). Данное утверждение необходимо переводить аккуратно, так как во многом его небрежное трактование привело к немыслимому количеству различных видов правила. Более того, нигде в русскоязычной литературе я не нашел перевода именно этой формулировки, являющейся исходной. Если мы переведем данную выше цитату, то получится следующий постулат: «Если аксон клетки А находится достаточно близко, чтобы возбуждать клетку B, и неоднократно или постоянно принимает участие в ее возбуждении, то наблюдается некоторый процесс роста или метаболических изменений в одной или обеих клетках, ведущий к увеличению эффективности А, как одной из клеток возбуждающих В».

Разберем данное утверждение и выделим основные следствия, которые могут быть выведены из представленной формулировки:

- Причинно-следственная связь. Основной смысл постулата Хебба заключается в том, что если изначально наблюдается причинно-следственная связь между активациями пре- и постсинаптического нейрона, то эта связь имеет тенденцию к усилению (про обратный закон Хебб в данной формулировке ничего не говорит).

- Местоположение изменений. Хебб указывает, что это усиление связанности происходит либо за счет изменения в проводимости синапса (процесс роста), либо за счет изменения метаболических особенностей самих клеток.

- Совокупное возбуждение. Хебб не случайно два раза (в начале и в конце формулировки) обращает наше внимание на то, что рассматриваемый пресинаптический нейрон является лишь одним из нейронов, которые принимают участие в возбуждении постсинаптического нейрона. Это утверждение, которое вполне понятно нейрофизиологам, для математиков является достаточно трудным. Такой формулировкой он указывает, что возбуждение постсинаптического нейрона не может быть осуществлено только за счет одного пресинаптического (спайк – это деполяризация мембраны нейрона, а разряд одного пресинатического нейрона никогда не может привести к деполяризации постсинаптического нейрона). В моделях искусственных нейронных сетей этот факт практически всегда нарушается, и к чему приводит такое несоответствие мы рассмотрим ниже.

Безусловно из постулата Хебба, можно вывести достаточно много следствий, однако названные выше выбраны не случайно, так как на их основе будет строится дальнейший анализ.

Различные трактовки и применения в ИНС

На просторах интернета и в различных (даже достаточно уважаемых и популярных) учебниках/книгах по теории нейронных сетей можно встретить самые различные формулировки правила Хебба. Например, Википедия дает нам даже два правила Хебба (ссылаясь на тот же самый труд 1949 года):

- Первое правило Хебба — Если сигнал перцептрона неверен и равен нулю, то необходимо увеличить веса тех входов, на которые была подана единица;

- Второе правило Хебба — Если сигнал перцептрона неверен и равен единице, то необходимо уменьшить веса тех входов, на которые была подана единица.

В данной трактовке есть целых три интересных момента, при этом присутствие двух из них совершенно необъяснимо. Первый из них – это раздвоенность правила (в дальнейшем я укажу возможные причины такой традиции в математической литературе), которой не было изначально у Хебба. Второй – наличие в формулировке правила понятия перцептрон, введение которого связывают с пионерскими работами Розенблатта только в 60-е (более конкретно в работе [2]). Третья особенность, которая вероятнее всего вытекает из второй, это достаточно своеобразная формулировка правила, фактически меняющая его тип на обучение с учителем. Изначально правило Хебба гласило о возможности самообучения, однако в такой постановке нам необходимо знать некоторые «правильные» значения выходов.

Вопрос о том, откуда появилось такая формулировка на Википедии, сводится к проблеме курицы и яйца, так как сейчас ее можно найти во многих местах на пространстве интернета, и концов соответственно невозможно отследить.

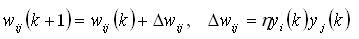

В большинство учебников по нейронным сетям правило Хебба вошло в несколько ином, однако очень похожем виде. Традиционная его запись такова (например в известной книге [3]):

Изначально, такое правило применялось к пороговым нейронам МакКалока-Питса, выход которых может быть соответственно равен либо 0, либо 1. При применении в формальной модели порогового нейрона интерпретация правила Хебба наиболее близка к оригинальной формулировке.

Однако, так как обычные пороговые нейроны достаточно неудобны с точки зрения построения ИНС для обработки данных (хотя с биологической точки зрения они возможно наиболее реалистичны, но это совсем другая тема), то сразу появились различные модификации.

В начале самое логичное было сделать такой же пороговый нейрон, но с другими возможными выходами: -1 и 1. На протяжении достаточно долгого времени именно такая модель нейрона была наиболее популярна. Однако, посмотрим к каким последствиям приводит применение обозначенной чуть выше формулировки правила Хебба в условиях данной модели. Вполне понятно, что это приводит к опять-таки раздваиванию исходного правила. Это происходит из-за того, что если выходы пре- и постсинаптического нейрона различны, то второе слагаемое в формуле корректировки веса принимает отрицательное значение, а значит исходное значение синаптического коэффициента уменьшается (иногда этот эффект называют антихеббовским правилом). Как мы могли убедиться ранее, в исходном постулате Хебба подобного механизма нет.

Есть две известных мне причины, по которым подобное допущение математикам могло показаться допустимым. Во-первых, применение исходного правила Хебба влечет к безграничному увеличению синаптических коэффициентов и, соответственно, к дестабилизации всей сети в целом. Во-вторых, во многих более ранних работах [4] Хебб сам давал подобный механизм, при котором синаптическая проводимость между двумя нейронами уменьшается, если спайки двух нейронов не совпадают. Однако, при формулировке окончательного постулата Хебб сознательно исключил такой механизм.

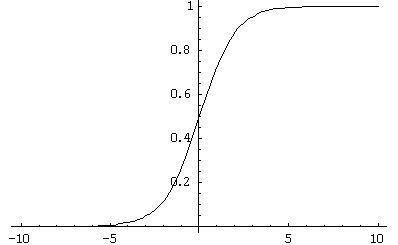

В дальнейшем ситуация начала усугубляться, с ростом популярности моделей нейронов с сигмоидальной активационной характеристикой (рис. 1). Как мы уже видели ранее, в математической литературе описано применение правила Хебба в случае обучения с учителем. Для введения сигмоидальной АХ в условиях обучения с учителем правило Хебба было модифицировано и превратилось в дельта-правило, которое слишком далеко от какой-либо биологической адекватности (именно поэтому я не буду обсуждать его в данной статье).

Рис. 1. Пример сигмоидальной функции активации

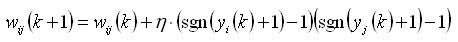

Однако, в случае самообучения модификации правила Хебба никто не делал и его применение к пороговым нейронам с выходами {-1;1} приводит к достаточно серьезным последствиям. Действительно, так как сигмоидальная функция непрерывна, то в подавляющем большинстве случаев выход нейрона не равен нулю. Таким образом, во-первых, обучение с применением традиционного правила Хебба происходит практически всегда, а во-вторых, динамика обучения теперь пропорциональна непосредственно значениям выходов нейронов (так как они по модулю непрерывны от 0 до 1). Последнее является достаточно сильным допущением, которое с нейрофизиологической точки зрения, насколько мне известно, никто никогда не проверял. Не смотря на это, в технических задачах данная методика дает результат, поэтому все закрыли на это глаза. Однако если формулировать правило Хебба по изначальной формулировке для сигмоидального нейрона, то должно получиться следующее:

Безусловно, в дальнейшем с приходом спайковых нейронов и обобщенного STDP-правила ситуация немного исправилась, однако даже на данный момент модели спайковых нейронов использует очень малая часть специалистов. Поэтому о кардинальном изменении положения говорить не приходится.

Правило Хебба и обучение

Возможно многие из вас задумаются над парадоксом названия, ведь правило Хебба и есть обучение, однако название заголовка выбрано не случайно. В предыдущих разделах мы рассмотрели историю и истоки постулата Хебба и несколько различных заблуждений, к которым привела неправильная трактовка этого правила. Сейчас же мы посмотрим на сам исходный нейрофизиологический постулат с точки зрения возможности применения его в системах бионического ИИ (и соответственно насколько вероятно его ведущая роль в процессах обучения у животных/человека).

Далее я сформулирую три соображения, суть которых будет сводиться, как минимум, к моим большим сомнениям в возможности построить самообучающиеся системы на основе правила Хебба (или любых его модификаций, коих невероятно много). Все соображения будут строится на анализе гипотетических ситуаций, при этом третье из них наименее формализовано, а второе – наиболее значимо.

Соображение 1. Усиление причинной связи

Если разобрать правило Хебба с точки зрения математика, то его действие фактически сводится к одной операции: усилению причинной связи. Получается, что изначально эта причинная связь должна уже наблюдаться, т.е. во-первых, нейроны должны быть синаптически связаны, во-вторых, нейроны должны быть синхронизованы (то есть должна наблюдаться последовательность – спайк на пресинаптическом нейроне -> спайк на постсинаптическом нейроне).

Представим гипотетическую ситуацию, когда находясь в какой-то внешней среде агент/животное обучилось, используя правило Хебба, решать некоторую задачу, которая приводит к адаптивному результату. Это означает, что улучшилась синаптическая проводимость путей распространения возбуждения между причинными нейронами (сама формулировка бросает меня в дрожь, так как далее я покажу откуда растут ее ноги). Отбросим в сторону изначальное доказательство возможности обучения, используя исключительно правило Хебба, и так как фактически мы идем от противного, примем эту ситуацию за отправную точку.

Теперь допустим, что среда несколько изменилась (самая частая ситуация в реальной жизни) и наш агент/животное не может достичь адаптивного результата способом, выученным ранее. Это означает, что агенту необходимо несколько переобучиться или дообучиться. При этом синаптическая проводимость настроена таким образом, чтобы с легкостью осуществлять заученное поведение. Переобучение в такой ситуации достаточно затруднительно, так как не смотря на изменившуюся ситуацию, натренерованные нейроны будут активироваться по цепочке, и не смотря ни на что будет осуществляться предыдущее поведение, которое не приводит к достижению результата.

Соображение 2. Потеря приобретенных знаний

Допустим, что обучение за счет изменения синаптической проводимости все-таки может происходить. Но тогда такое обучение неизбежно влечет к потере информации (ранее полученных сведений о среде), которая распределена по всей сети. Это легко понять, если представить, что пространство весовых коэффициентов – есть поле, в котором хранятся все «знания» сети, и поэтому меняя это поле, мы не добавляем новые «знания», а перезаписываем все накопленные.

Так как это соображения является наиболее важным, то здесь необходимо привести более подробный пример. В качестве такового я рассмотрю поведение робота DARWIN [5], разработанного в лаборатории Джеральда Эдельмана, в так называемом лабиринте Морриса.

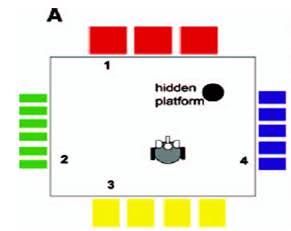

Исследования поведения мыши или крысы в лабиринте Морриса – один из канонических биологических экспериментов, который состоит в следующем. Имеется бассейн с непрозрачной жидкостью (например, это может быть вода, подкрашенная молоком), на бортах бассейна есть рисунки, которые мышь видит и может использовать для ориентировки. В определенном месте бассейна есть скрытая платформа, которую мышь может найти и тем самым спастись – не утонуть. Мышь бросают в бассейн, она плавает некоторое время и либо находит платформу и спасается, либо начинает тонуть (тогда ее спасает экспериментатор). После ряда экспериментов мышь начинает использовать ориентиры на бортах бассейна и находить платформу за достаточно короткое время. Схематическое изображение такого лабиринта приведено на рис. 2.

Рис. 2. Схематичное изображение лабиринта Морисса

Сам робот DARWIN устроен достаточно сложно – в нем моделируются несколько реальных областей мозга и их связи, в дополнение несколько оригинальных структур (всего управляющая нейронная сеть насчитывает 90000 нейронов). Сейчас нам важно знать, что обучение робота происходит за счет модифицированного специальным образом правила Хебба.

Робот помещается в лабиринт Морисса и учится находить платформу, ориентируясь по рисункам на бортах. При этом в результате DARWIN достаточно быстро и эффективно учится находить платформу. Для дальнейших рассуждений нам будет необходимо представить цепочку таких опытов.

Допустим, робот научился эффективно находить платформу. Назовем данный процесс обучения – эксперимент 1. Теперь переместим платформу куда-нибудь в другое место и опять поместим робота в лабиринт Морриса (это будет эксперимент 2). В какой-то момент роботу станет «понятно», что платформа переместилась и он начнет поиски заново. Припоминая, что в начале обсуждения данного соображения мы временно приняли за постулат, что переобучение за счет правила Хебба принципиально возможно, будем считать, что робот и в эксперименте 2 показал себя молодцом и снова научился эффективно находить платформу.

Самое интересное начинается тогда, когда мы попробуем провести эксперимент 3, еще раз переместив платформу куда-нибудь. В этом случае ситуация будет аналогична эксперименту 2 – робот снова поймет, что платформа переместилась, и найдет новое ее положение. Вроде бы все хорошо, однако самым важным в данном случае является процесс решения. В случае DARWIN процесс решения в эксперименте 2 и эксперименте 3 будет совершенно аналогичен. Робот даже не вспомнит о том, что им были получены какие-то знания в эксперименте 1, так как их фактически уже нет – они были перезаписаны в процессе эксперимента 2.

В случае же реального животного ситуация с процессом решения в рамках эксперимента 3 совершенно иная. В начале понятно, что животное начнет искать платформу в месте, которое она выучила в эксперименте 2. Однако, не найдя ее там, она первым делом проверит место, в котором была платформа в эксперимент 1. Эта важнейшая особенность является чрезвычайно адаптивной в очень многих ситуациях, с которыми сталкивается животное в процессе своей жизни. Кстати, подобная проверка применительно к системе DARWIN была придумана не мной, а моим научным руководителем.

Потеря приобретенных знаний – это неизбежное следствие любых модификаций правила Хебба.

Соображение 3. Рефлекторная природа правила Хебба

По своей сути правило Хебба является реактивностным постулатом. Его применение выливается в упрощение последовательной активации цепочки нейронов. Это очень схоже с понятием рефлекторной дуги и обучения, основанном на тренировке этой дуги и облегчении прохождении сигнала по ней. При этом к подобным умозаключениям приходил в свое время еще Кант в своих записях, которые непосредственно относились к возможностью человеческого разума обучаться.

С моей точки зрения, очень сомнительно, что применение правила Хебба (хочу уточнить, что в случае применения только правила Хебба) может приводить к целенаправленному обучению и в конечном итоге достижению адаптивного результата. Само понятие целенаправленного отсутствует в правиле, а также в любых его анализах, которые мне приходилось видеть.

С учетом того, что к нам приходит отчетливое понимание того факта, что мозг (и каждый нейрон) является активной, а не реактивной сущностью, неизбежен пересмотр роли постулата Хебба в обучении животных и человека.

Что делать?

В чем же заключается выход из этой ситуации спросите вы?

Мой ответ будет заключаться в необходимости разработки совершенно новых подходов к моделированию обучения. На данный момент правило Хебба и его многочисленные модификации по сути являются единственными биологически адекватными моделями обучения/самообучения. Безусловно, это не случайно, так как нейрофизиологический постулат, выдвинутый Хеббом, имеет под собой прочное биологическое основание.

При всей моей критике постулата Хебба, я вовсе не хотел сказать, что мы не наблюдаем его в мозге животных. Наблюдаем конечно и этому посвящено множество известнейших работ. Я хотел лишь обратить ваш критический взгляд на роль этого постулата в обучении.

Я придерживаюсь позиции, что изменение синаптической проводимости безусловно является одним из основных факторов обеспечивающих эффективное обучение. Однако, этим процессом и самим постулатом Хебба управляют гораздо более сложные факторы – системный уровень организации мозга. При этом сам постулат является лишь ограниченным следствием из всей совокупности механизмов системного уровня.

Заключение

В данном обзоре мы прошлись от истории постулата Хебба до оценки его возможностей и перспектив в реализации обучения. Я попытался обратить ваше внимание на некоторые проблемы, которые возникают в том случае, если мы ставим механизмы правила Хебба во главу угла при обучении.

Повторюсь, сейчас, как никогда, мы вплотную столкнулись с острой необходимостью формулировки совершенно иных, более комплексных, механизмов адаптивного (целенаправленного) обучения. Как работает этот, условно называемый системным, уровень на сегодняшний день мы не знаем – существуют только гипотезы. Каким образом, системный уровень обеспечивается за счет изменения синаптической проводимости и изменения в самих нейроных – еще более сложный вопрос, ответ на который мы возможно получим не скоро. Именно поэтому, на данный момент специалистам в области бионического ИИ остается вводить более абстрактные правила (при этом оперирующие все равно непосредственно с нейронами и синапсами), которые будут моделировать системные механизмы обучения, памяти, принятие решения.

Список литературы

[1]. Hebb, D. O. The organization of behavior: a neuropsychological theory. New York (2002) (Оригинальное издание — 1949)

[2]. Rosenblatt F. Principles of Neurodynamics: Perceptrons and the Theory of Brain Mechanisms. Washington, DC: Spartan Books (1962).

[3]. Осовский С. Нейронные сети для обработки информации (2002)

[4]. Hebb, D. O. Conditioned and unconditioned reflexes and inhibition. Unpublished MA Thesis, McGill University, Montreal, Quebec, (1932)

[5]. Krichmar J.L., Seth A.K., Nitz D.A., Fleischer J.G., Edelman G.M. «Spatial navigation and

causal analysis in a brain-based device modeling cortical-hippocampal interactions». Neuroinformatics, 2005. V. 3. No. 3. PP. 197-221.