Доброго времени суток всем гикам и непростым людям со странными запросами. Надеюсь тут есть люди которые не довольны скоростью в гигабит и мечтают о скоростях в 10 гигабит, а то и 100. На данный момент появились уже достаточно дешевые решения в виде сетевых карт pci-e с двумя портами форм-фактора sfp+, которые можно соединить посредством дешевого твинаксиального кабеля.

Под катом небольшие размышления о 10 гигабитном thunderbolt от интел, описание двухпортовой сетевой карточки от интел и твинаксиального кабеля, скрины с freebsd, linux, windows и много фоток.

Не так давно engadget начал будоражить мой мозг интерфейсом thunderbolt, который должен появиться в новых макбуках и показывает ролики со скоростями в 600-800 мегабайт в секунду с NAS Pegasus от компании PROMISE. Promise обещал выпустить свой NAS в продажу в apple store во втором квартале этого года, и судя по всему это было бы первое устройство с интерфейсом thunderbolt, но увы в продаже найти его мне не удалось. Intel обещает что интерфейс будет дешевым и домашним, с небольшой длиной кабеля если кабель медный и большой длинной если оптический, скорость до 10 гигабит, а так же разделяемая среда(вспоминаем одноранговые сети на коаксиале). Но увы устройств нет, цены тоже никто не назвал, а 10 гигабит хочется уже сейчас.

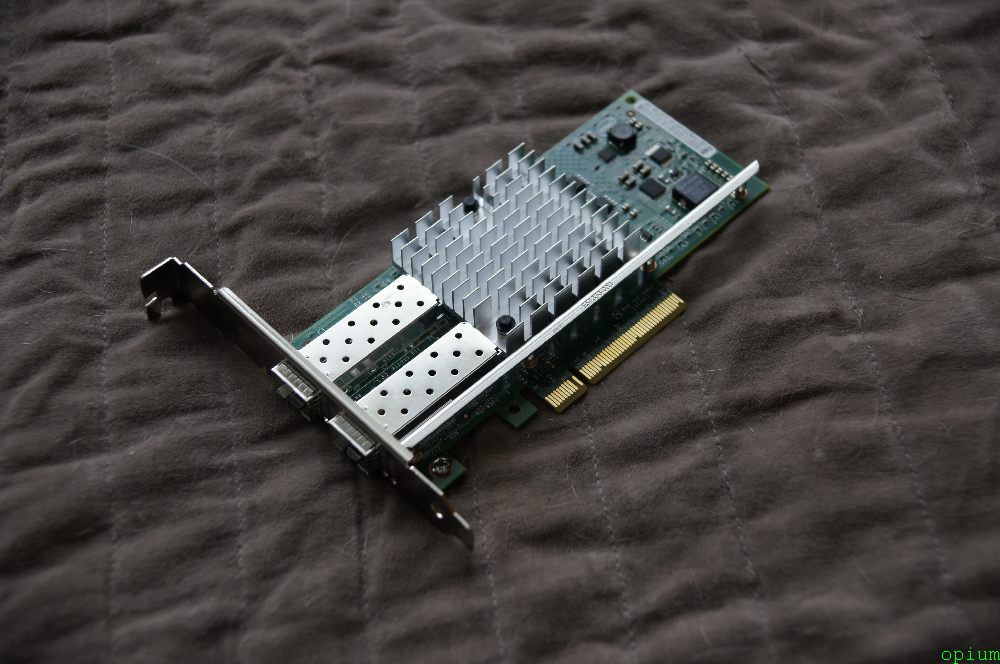

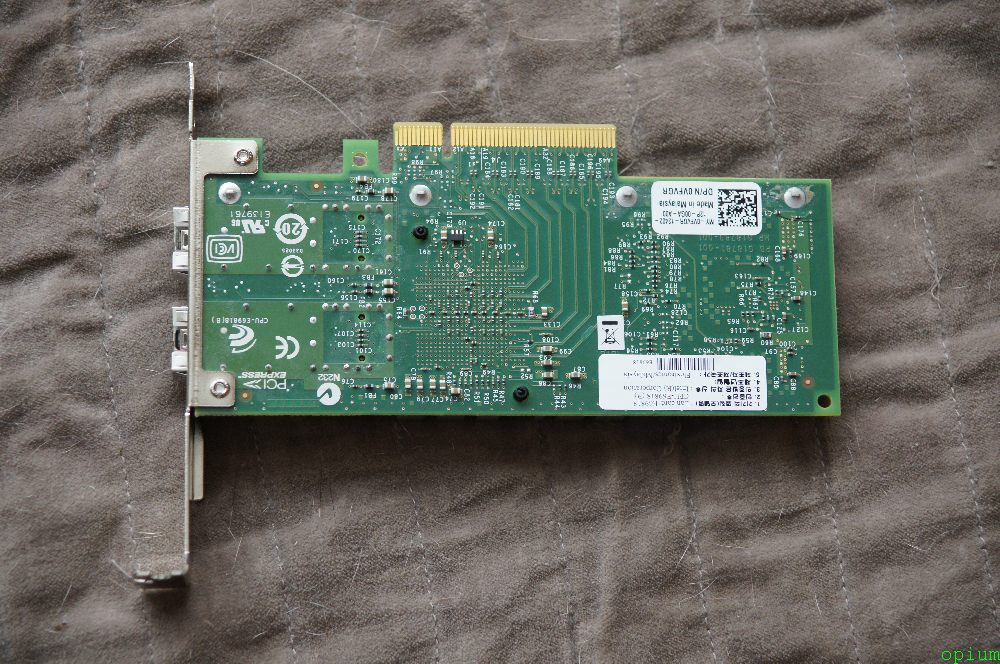

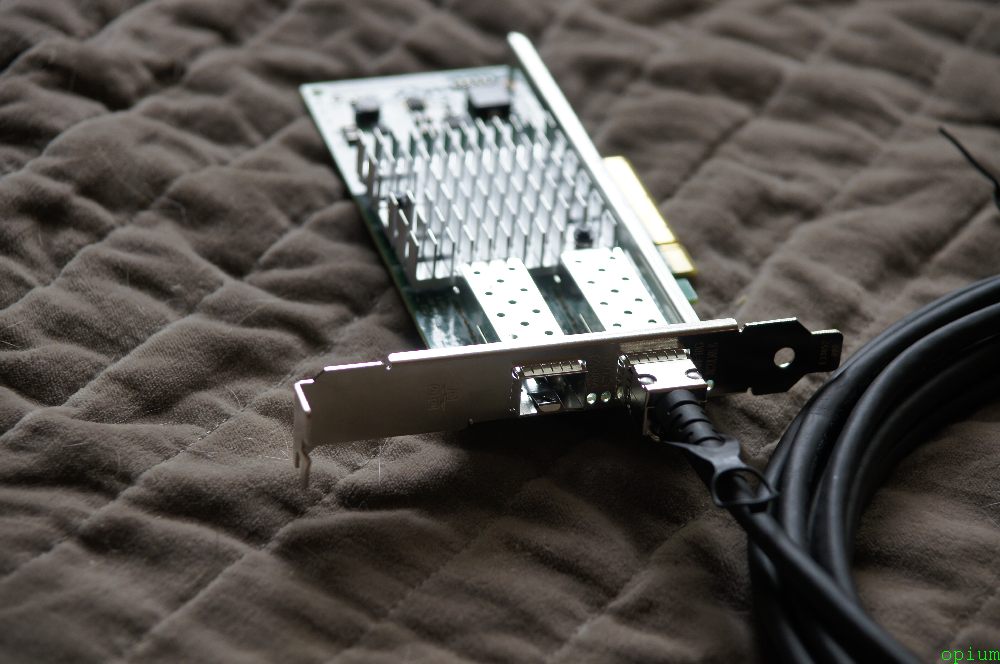

Пару лет назад рассматривал 10g решения и цены там были на уровне 30к рублей на порт + оптика и прочий геморой для дома не особо доступный. Но сейчас интел выпустил сетевую карту с двумя портами sfp+ с поддержкой скорости в 10g стоимостью 9-10к рублей(Intel X520 DA2 10GbE Dual Port SFP+), карты можно соединять дешевым твинаксиальным кабелем от компании Dell стоимость 2-3к рублей(5M SFP+ Direct Attach Twinaxial Cable).

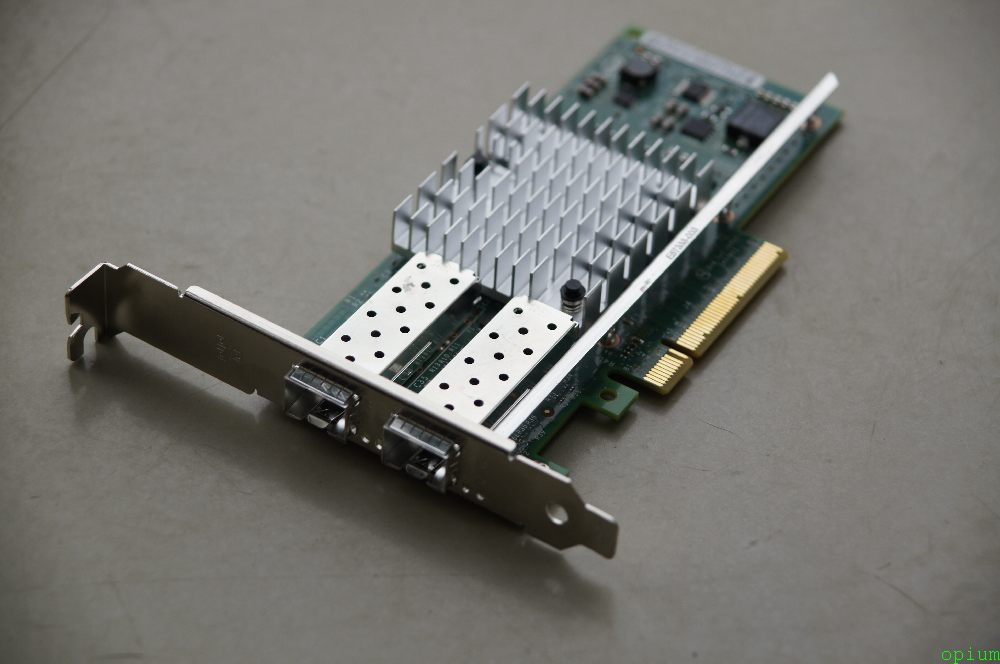

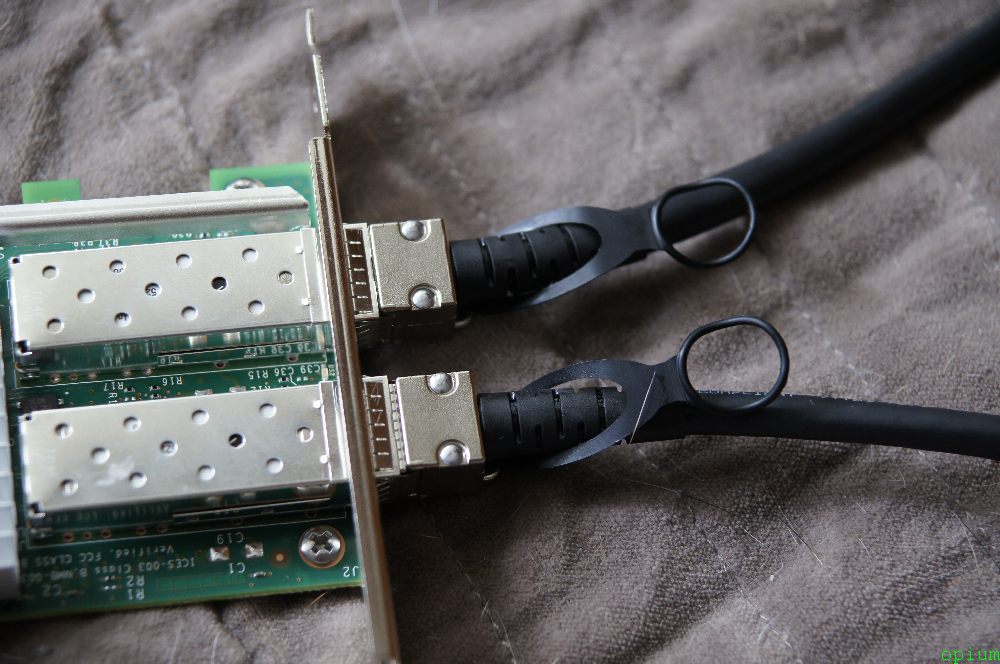

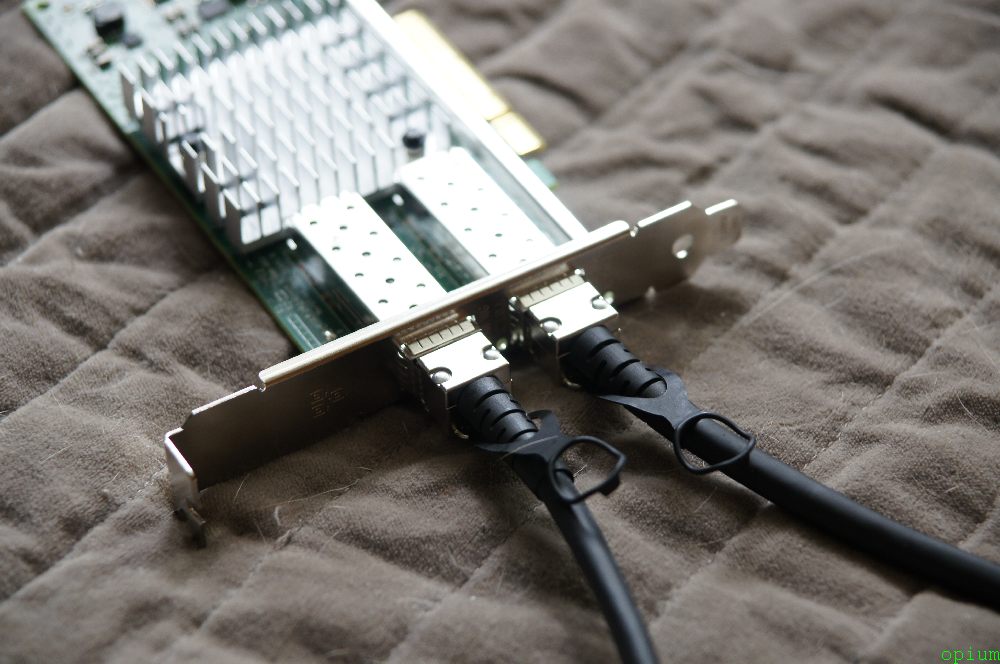

Сетевая карта Intel X520 DA2 предназначена для систем виртуализации поэтому в ней два порта. Один используется для общения с глобальной сетью, а второй для общения с внешним хранилищем по iscsi или по fcoe где хранятся образы виртуальных машин, но никто не запрещает использовать её в объединении канала и получить 20 гигабитный линк. В карточку можно вставить модули sfp+ с 10g оптическим интерфейсом(дорого) или же твинаксиальный кабель(дешево). Как соединяется кабель с карточкой видно на фотографиях внизу статьи.

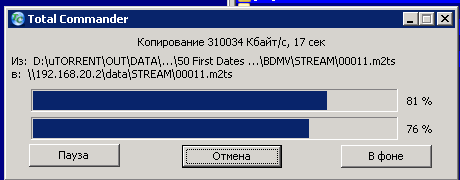

Я решил купить три карточки и три кабеля, чтобы соединить три сервера в 10 гигабитное кольцо, у серверов разные операционные системы, на данный момент я потестил только скорость между freenas и windows? получил 300 мегабайт между ними, на виндовсе собран 5-ый софтовый raid из 5 винчестеров, на фринасе zfs raidz2 из 20 винтов. Думаю что все упирается в виндовый raid позже проведу тесты с линуксом и думаю смогу получить почти 10 гигабит скорости между хранилищами. Стоимость всего этого дела вышла в 9500*3+2500*3= 36 000 рублей.

Для этого дела можно ещё приобрести свич, но моделей дешевле 100 тысяч я пока не нашел, ну думаю и такие уже не за горами.

Вот так выглядит сетевая карта во freenas:

freenas# ifconfig

ix0: flags=8943<UP,BROADCAST,RUNNING,PROMISC,SIMPLEX,MULTICAST> metric 0 mtu 1500

options=1bb<RXCSUM,TXCSUM,VLAN_MTU,VLAN_HWTAGGING,JUMBO_MTU,VLAN_HWCSUM,TSO4>

ether 00:1b:21:a3:94:7c

media: Ethernet autoselect

status: no carrier

ix1: flags=8943<UP,BROADCAST,RUNNING,PROMISC,SIMPLEX,MULTICAST> metric 0 mtu 1500

options=1bb<RXCSUM,TXCSUM,VLAN_MTU,VLAN_HWTAGGING,JUMBO_MTU,VLAN_HWCSUM,TSO4>

ether 00:1b:21:a3:94:7d

media: Ethernet autoselect (10Gbase-Twinax <full-duplex>)

status: active

Вот так в linux ubuntu:

root@ubuntu:~# ifconfig

eth2 Link encap:Ethernet HWaddr 00:1b:21:a3:c3:6c

inet addr:192.168.20.5 Bcast:192.168.20.255 Mask:255.255.255.0

inet6 addr: fe80::21b:21ff:fea3:c36c/64 Scope:Link

UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1

RX packets:22946932 errors:0 dropped:0 overruns:0 frame:0

TX packets:4925414 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:1554581575 (1.5 GB) TX bytes:975549697 (975.5 MB)

eth3 Link encap:Ethernet HWaddr 00:1b:21:a3:c3:6d

UP BROADCAST MULTICAST MTU:1500 Metric:1

RX packets:0 errors:0 dropped:0 overruns:0 frame:0

TX packets:0 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:0 (0.0 B) TX bytes:0 (0.0 B)

root@ubuntu:~# ethtool eth2

Settings for eth2:

Supported ports: [ FIBRE ]

Supported link modes: 10000baseT/Full

Supports auto-negotiation: No

Advertised link modes: 10000baseT/Full

Advertised pause frame use: No

Advertised auto-negotiation: No

Speed: 10000Mb/s

Duplex: Full

Port: Direct Attach Copper

PHYAD: 0

Transceiver: external

Auto-negotiation: off

Supports Wake-on: d

Wake-on: d

Current message level: 0x00000007 (7)

Link detected: yes

root@ubuntu:~# ethtool eth3

Settings for eth3:

Supported ports: [ FIBRE ]

Supported link modes: 10000baseT/Full

Supports auto-negotiation: No

Advertised link modes: 10000baseT/Full

Advertised pause frame use: No

Advertised auto-negotiation: No

Speed: Unknown!

Duplex: Unknown! (255)

Port: Direct Attach Copper

PHYAD: 0

Transceiver: external

Auto-negotiation: off

Supports Wake-on: d

Wake-on: d

Current message level: 0x00000007 (7)

Link detected: no

Вот так в windows:

Вопросы, пожелания, предложения?

Все кому не жалко скиньте денег на еду:

Яндекс деньги: 41001350134938

wmr: R216907812321

wmz: Z115984864021

Приму в дар хороший фотоаппарат, высокотехнологичное железо для обзоров, интересные штуки(предлагайте сами), тему для обзора или освещения.

Не жалеем карму и плюсы.

UPD1: По просьбе в комментариях прикладываю скрин копирования с тотала(скорость будет выше в тестах на линуксе).

Ну а теперь самое вкусное — фотки: