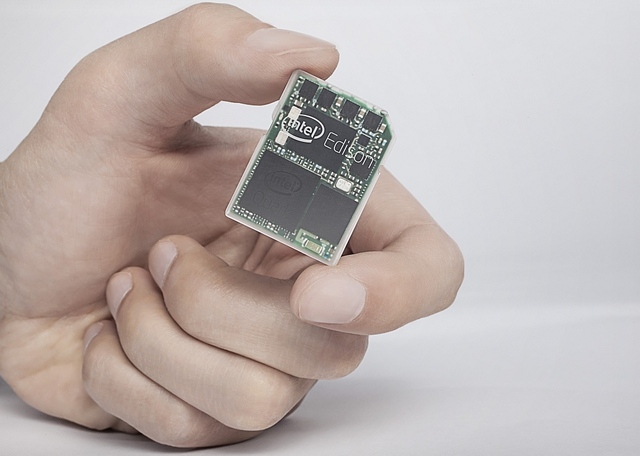

Сегодня, на выставке CES 2014 Intel представил двухядерный компьютер размером с SD-карту со встроенным WiFi и Bluetooth на представленной ранее Quark SoC. Кроме того, компьютер работает на ОС Linux и может конектиться к специальному app store.

Предполагается, что компьютер будет использоваться для разработких новых носимых устройств, и Intel не был бы Intel если бы не создал поощрительное соревнование по разработке таких устройств — «Make it Wearable» с призовым фондом в $1,3млн и $500,000 за первое место был обьявлен сразу же на выставке.