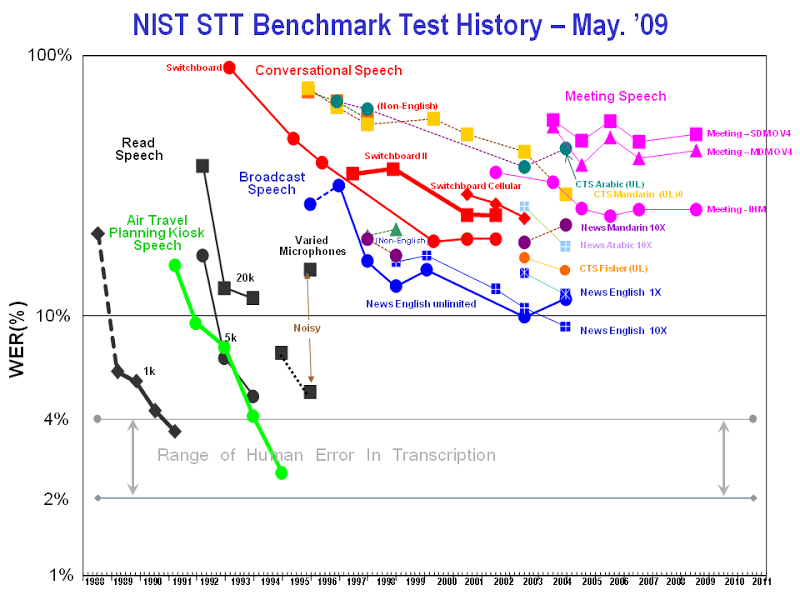

Предполагалось, что когда компьютер научится понимать человеческую речь, мы быстро сможем создать искусственный интеллект. Но точность систем распознавания речи достигла своего пика в 1999 году и с тех пор застыла на месте. Академические тесты 2006 года констатируют факт: системы общего профиля так и не преодолели уровень 80%, тогда как у человека этот показатель составляет 96-98%.

Профессор Роберт Фортнер из Media Research Institute считает, что создатели систем распознавания речи окончательно зашли в тупик. Программисты сделали всё что смогли, и у них не получилось. Спустя несколько десятилетий они поняли, что человеческая речь — не просто набор звуков. Акустический сигнал не несёт достаточно информации для распознавания текста.

Сложность задачи можно себе представить. По некоторым оценкам, количество возможных предложений в человеческом языке составляет 10570. В документированных источниках зафиксирована лишь малая их часть, так что систему невозможно научить, даже если «скормить» ей все тексты, созданные людьми.

У многих слов в языке — сотни или тысячи значений. Выбор конкретного значения зависит от контекста, то есть от окружающих слов. В устной речи он ещё зависит от выражения лица или от интонации.

Наш мозг способен генерировать текст совершенно произвольно, используя интуитивно понятные правила функциональной грамматики и усвоенную с возрастом семантическую парадигму каждого слова. Эти правила описывают, какие слова могут сочетаться друг с другом и каким образом (через какие функциональные элементы). Значение каждого слова зависит от значения предыдущего слова, а в сложных случаях наш мозг распознаёт речь лишь по обрывкам фраз, зная контекст.

Базовые правила функциональной грамматики понятны каждому человеку, но их никак не удаётся формализовать, чтобы стало понятно и компьютеру. А без этого никак. Когда компьютер пытается распознать ранее не встречавшиеся ему предложения, он неизбежно будет допускать ошибки в распознавании, если у него нет грамматического парсера и словаря с семантическими парадигмами, встроенного в человеческий мозг.

Например, российские лингвисты когда-то попытались составить семантическую парадигму одного простого предлога русского языка (кажется, ПРИ). Они дошли до нескольких сотен значений, каждое из которых допускает свой набор последующих элементов. И это был явно не полный список.

По грамматике предлогов проводятся целые научные конференции (некоторые учёные всю жизнь изучают предлог ПО и не могут до конца раскрыть его тайны). А ведь подобное описание требуется для каждой морфемы человеческого языка, включая приставки и суффиксы. Только после этого можно будет приступить к программированию компьютерных систем распознавания речи. По силам ли человечеству эта задача? Ведь нужно учесть ещё, что парадигма каждого элемента человеческой речи постоянно меняется, ведь язык живёт своей жизнью и всё время эволюционирует. Как компьютерная система сможет самообучаться?

Самый поверхностный анализ опубликованных текстов в интернете компанией Google позволил выявить триллион объектов. Это лишь мизерная часть морфем, из которых состоит наша речь. Google выложил 24-гигабайтный архив с текстами во всеобщий доступ и прекратил дальнейшие публикации по этой теме.

Проект MindNet по созданию «универсального парсера» компания Microsoft начала в 1991 году. Они пытались построить универсальную карту всех возможных взаимосвязей между словами. На проект потратили много сил и финансовых средств, но были вынуждены практически прекратить исследования в 2005 году.

Можно поставить точку и начинать всё сначала, только другим способом (гораздо более сложным). Язык необходимо формализовать в рамках единой функциональной грамматики, универсальной для всех языков, и без серьёзной помощи лингвистов тут не обойтись, если задача вообще решаема.

Профессор Роберт Фортнер из Media Research Institute считает, что создатели систем распознавания речи окончательно зашли в тупик. Программисты сделали всё что смогли, и у них не получилось. Спустя несколько десятилетий они поняли, что человеческая речь — не просто набор звуков. Акустический сигнал не несёт достаточно информации для распознавания текста.

Сложность задачи можно себе представить. По некоторым оценкам, количество возможных предложений в человеческом языке составляет 10570. В документированных источниках зафиксирована лишь малая их часть, так что систему невозможно научить, даже если «скормить» ей все тексты, созданные людьми.

У многих слов в языке — сотни или тысячи значений. Выбор конкретного значения зависит от контекста, то есть от окружающих слов. В устной речи он ещё зависит от выражения лица или от интонации.

Наш мозг способен генерировать текст совершенно произвольно, используя интуитивно понятные правила функциональной грамматики и усвоенную с возрастом семантическую парадигму каждого слова. Эти правила описывают, какие слова могут сочетаться друг с другом и каким образом (через какие функциональные элементы). Значение каждого слова зависит от значения предыдущего слова, а в сложных случаях наш мозг распознаёт речь лишь по обрывкам фраз, зная контекст.

Базовые правила функциональной грамматики понятны каждому человеку, но их никак не удаётся формализовать, чтобы стало понятно и компьютеру. А без этого никак. Когда компьютер пытается распознать ранее не встречавшиеся ему предложения, он неизбежно будет допускать ошибки в распознавании, если у него нет грамматического парсера и словаря с семантическими парадигмами, встроенного в человеческий мозг.

Например, российские лингвисты когда-то попытались составить семантическую парадигму одного простого предлога русского языка (кажется, ПРИ). Они дошли до нескольких сотен значений, каждое из которых допускает свой набор последующих элементов. И это был явно не полный список.

По грамматике предлогов проводятся целые научные конференции (некоторые учёные всю жизнь изучают предлог ПО и не могут до конца раскрыть его тайны). А ведь подобное описание требуется для каждой морфемы человеческого языка, включая приставки и суффиксы. Только после этого можно будет приступить к программированию компьютерных систем распознавания речи. По силам ли человечеству эта задача? Ведь нужно учесть ещё, что парадигма каждого элемента человеческой речи постоянно меняется, ведь язык живёт своей жизнью и всё время эволюционирует. Как компьютерная система сможет самообучаться?

Самый поверхностный анализ опубликованных текстов в интернете компанией Google позволил выявить триллион объектов. Это лишь мизерная часть морфем, из которых состоит наша речь. Google выложил 24-гигабайтный архив с текстами во всеобщий доступ и прекратил дальнейшие публикации по этой теме.

Проект MindNet по созданию «универсального парсера» компания Microsoft начала в 1991 году. Они пытались построить универсальную карту всех возможных взаимосвязей между словами. На проект потратили много сил и финансовых средств, но были вынуждены практически прекратить исследования в 2005 году.

Можно поставить точку и начинать всё сначала, только другим способом (гораздо более сложным). Язык необходимо формализовать в рамках единой функциональной грамматики, универсальной для всех языков, и без серьёзной помощи лингвистов тут не обойтись, если задача вообще решаема.